robots协议设置如何控制搜索引擎索引频率 (robots中文翻译)

在SEOwz/53830.html" target="_blank">网站优化和搜索引擎优化(SEO)的实践中,robots协议是一个不可忽视的重要工具。通过合理设置robots协议,网站管理员可以有效控制搜索引擎爬虫对网站内容的访问频率和抓取范围。robots协议的全称是“robots.txt”,它是一种标准协议,用于告知搜索引擎哪些页面可以抓取,哪些页面应该避免抓取。尽管robots协议本身并不能直接控制索引频率,但它通过影响爬虫的抓取行为,间接地对索引频率产生影响。

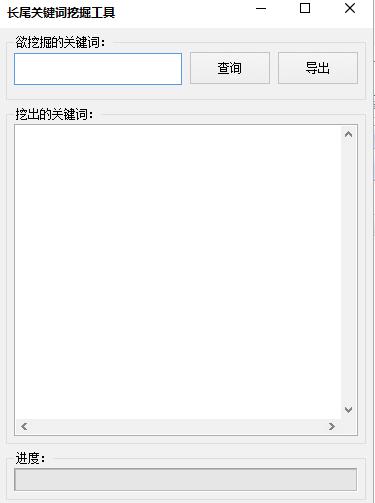

我们需要理解robots协议的基本结构和语法。robots.txt文件通常位于网站的根目录下,搜索引擎爬虫在访问网站时会首先查找该文件,以确定允许抓取的内容范围。该文件由一组规则组成,每组规则以“User-agent”开头,指定适用于哪些搜索引擎爬虫,随后是“Disallow”和“Allow”指令,用于定义禁止或允许抓取的路径。例如:

User-agent:

Disallow: /admin/

Allow: /

在这个例子中,“User-agent: ”表示适用于所有搜索引擎爬虫,“Disallow: /admin/”表示禁止爬虫访问网站的“/admin/”路径,而“Allow: /”表示允许爬虫抓取网站的其他部分。通过这种方式,网站管理员可以限制搜索引擎爬虫的访问范围,从而控制哪些内容可以被索引。

robots协议对索引频率的影响主要体现在两个方面。第一,通过限制爬虫的抓取范围,robots协议可以减少搜索引擎对网站的访问次数,从而降低服务器负载。这对于资源有限的网站来说尤为重要,因为过多的爬虫访问可能导致服务器响应变慢,甚至崩溃。第二,robots协议可以帮助网站管理员优先展示最重要的内容。例如,如果网站有大量重复内容或低质量页面,可以通过robots协议阻止搜索引擎爬虫抓取这些页面,从而将爬虫的注意力集中在高质量内容上,提高这些内容被索引的可能性。

robots协议并不能直接控制索引频率。索引频率主要由搜索引擎的算法决定,包括网站的更新频率、内容质量、外部链接数量等因素。即使某个页面被允许抓取,搜索引擎也可能根据其自身策略决定是否将其收录以及收录的频率。因此,robots协议的作用更多是“引导”而非“强制”。它可以帮助网站管理员优化爬虫的行为,但不能完全控制搜索引擎的索引策略。

为了更有效地控制索引频率,网站管理员可以结合其他工具和技术。例如,使用Sitemap(站点地图)可以帮助搜索引擎更高效地发现网站的重要页面。Sitemap是一个XML文件,列出了网站中所有希望被搜索引擎收录的页面,并提供了每页的更新频率、优先级等信息。通过向搜索引擎提交Sitemap,可以提高重要页面的索引频率。

网站管理员还可以通过Google Search Console等工具监控搜索引擎爬虫的抓取行为,并根据实际情况调整robots协议。例如,如果发现某个页面被频繁抓取但并未带来实际流量,可以考虑在robots.txt中限制该页面的抓取权限,从而将爬虫资源集中在更有价值的页面上。

需要注意的是,robots协议的设置需要谨慎,错误的配置可能导致重要页面被误屏蔽,影响网站的搜索引擎可见性。例如,如果在robots.txt中错误地禁止了网站主页的抓取,搜索引擎将无法访问整个网站,导致网站内容从搜索结果中消失。因此,在设置robots协议时,建议使用在线验证工具进行检查,确保规则的准确性和有效性。

robots协议是网站管理中不可或缺的一部分,它通过控制搜索引擎爬虫的抓取行为,间接影响索引频率。合理设置robots协议可以帮助网站优化爬虫访问,提高服务器性能,并引导搜索引擎优先收录高质量内容。robots协议并非万能,它需要与其他SEO工具和策略结合使用,才能实现最佳效果。网站管理员应根据自身需求,灵活运用robots协议,确保网站内容在搜索引擎中的良好表现。

本文地址: https://itc.gsd4.cn/wzseowz/43257.html